Système d'exploitation

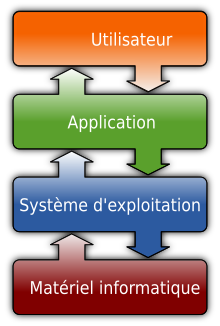

En informatique, un système d'exploitation (souvent appelé OS — de l'anglais Operating System) est un ensemble de programmes qui dirige l'utilisation des ressources d'un ordinateur par des logiciels applicatifs[1]. Il reçoit des demandes d'utilisation des ressources de l'ordinateur — ressources de stockage des mémoires (par exemple des accès à la mémoire vive, aux disques durs), ressources de calcul du processeur central, ressources de communication vers des périphériques (pour parfois demander des ressources de calcul au GPU par exemple ou tout autre carte d'extension) ou via le réseau — de la part des logiciels applicatifs. Le système d'exploitation gère les demandes ainsi que les ressources nécessaires, évitant les interférences entre les logiciels[1].

Le système d'exploitation est un logiciel, le deuxième et le principal programme exécuté lors de la mise en marche de l'ordinateur[2], le premier étant le programme d'amorçage (appelé également bootloader). Il offre une suite de services généraux facilitant la création de logiciels applicatifs et sert d'intermédiaire entre ces logiciels et le matériel informatique[1]. Un système d'exploitation apporte commodité, efficacité et capacité d'évolution, permettant d'introduire de nouvelles fonctions et du nouveau matériel sans remettre en cause les logiciels[2].

Il existe sur le marché des dizaines de systèmes d'exploitation différents[2], très souvent livrés avec l'appareil informatique[3]. C'est le cas de Windows, Mac OS, Irix, Symbian OS, GNU/Linux, (pour ce dernier il existe de nombreuses distributions) ou Android. Les fonctionnalités offertes diffèrent d'un système à l'autre et sont typiquement en rapport avec l'exécution des programmes, l'utilisation de la mémoire centrale ou des périphériques, la manipulation des systèmes de fichiers, la communication, ou la détection et la gestion d'erreurs[2].

La définition des systèmes d'exploitation est rendue floue par le fait que les vendeurs de ces produits considèrent le système d'exploitation comme étant la totalité du contenu de leur produit, y compris les vidéos, les images et les logiciels applicatifs l'accompagnant[1], sans compter les modifications des constructeurs informatiques (dans les cas de licences OEM) qui compliquent la donne.

En 2012, les deux familles de systèmes d'exploitation les plus populaires sont Unix (dont macOS, GNU/Linux, iOS et Android) et Windows. Cette dernière détient un quasi-monopole sur les ordinateurs personnels avec près de 90 % de part de marché depuis 15 ans[4].

Le système d'exploitation est un intermédiaire entre les logiciels d'application et le matériel.

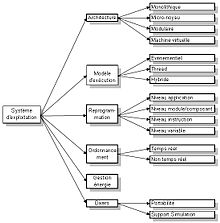

Relations dans un système d'exploitation moderne.

Sommaire

1 Fonctionnalités

1.1 Utilisation

1.2 Processeur

1.3 La communication inter-processus

1.4 Mémoire

1.4.1 La mémoire virtuelle

1.5 Périphériques

1.6 Fichiers

1.7 Réseau

1.8 Contrôle d'accès

1.9 Interface utilisateur

1.9.1 Interface graphique

1.10 Logiciels utilitaires

2 Typologie

2.1 Première génération : Traitement par lots

2.2 Deuxième génération : la multiprogrammation

2.3 Troisième génération : le temps partagé

2.4 Quatrième génération : le temps réel

2.5 Cinquième génération : les systèmes distribués

3 Histoire

3.1 1960, la multiprogrammation

3.2 1972, les micro-ordinateurs

3.3 1990, les systèmes d'exploitation sous licence libre

4 Organisation générale du noyau

4.1 Noyau monolithique

4.2 Noyau à micronoyau

4.3 Noyau hybride

4.4 Système organisé par couches

4.5 Appels système

4.6 Noyau client-serveur

4.7 Principe de machine virtuelle

5 Quelques exemples

6 Le marché

6.1 Choix par l'acheteur

6.2 Concurrence, compatibilité et interopérabilité

6.2.1 La guerre des Unix et l'Open Group

6.2.2 Microsoft et la concurrence

6.2.3 Les réseaux informatiques

7 Notes et références

7.1 Notes

7.2 Références

7.3 A.Tanenbaum, Systèmes d'exploitation

8 Bibliographie

9 Annexes

9.1 Articles connexes

9.2 Liens externes

Fonctionnalités |

Le système d'exploitation offre une suite de services généraux facilitant la création et l'utilisation de logiciels applicatifs. Les services offerts sont en rapport avec l'utilisation des ressources de l'ordinateur par les programmes[2]. Ils permettent en particulier d'exécuter des programmes, de lire et écrire des informations, de manipuler les fichiers, de communiquer entre ordinateurs et de déceler des erreurs[2]. Ces services permettent à plusieurs usagers et plusieurs programmes de se partager les ressources de l'ordinateur[5]. Le principal rôle du système d'exploitation est alors de gommer les différences entre les différentes architectures informatiques, et d'organiser l'utilisation des ressources de façon rationnelle :

- Utilisation des périphériques : chaque périphérique a ses propres instructions, avec lesquelles il peut être manipulé. Le système d'exploitation en tient compte. Il permet au programmeur de manipuler le périphérique par de simples demandes de lecture ou d'écriture, lui évitant la perte de temps de traduire les opérations en instructions propres au périphérique[5].

- Accès aux fichiers : en plus des instructions propres à chaque périphérique (lecteur de disquette, disque dur, lecteur de CD-ROM), le système d'exploitation tient compte du format propre de chaque support servant au stockage de fichiers. Il offre également des mécanismes de protection permettant de contrôler quel utilisateur peut manipuler quel fichier[5].

- L'accès aux ressources : Une des fonctions du système d'exploitation est de protéger les ressources contre l'utilisation par des personnes non autorisées, et de résoudre les conflits lorsque deux utilisateurs demandent simultanément la même ressource[5].

- Détection et récupération en cas d'erreur : lorsqu'une erreur survient, qu'elle soit matérielle ou logicielle, le système d'exploitation traite l'erreur en adoucissant son impact sur le système informatique. Il peut tenter de réitérer l'opération, arrêter l'exécution du programme fautif, ou signaler le problème à l'utilisateur[5].

- Contrôle : un système d'exploitation peut tenir des statistiques d'utilisation des ressources, surveiller la performance, et les temps de réponse[5].

La palette des services offerts et la manière de s'en servir diffère d'un système d'exploitation à l'autre. Le standard industriel POSIX du IEEE définit une suite d'appels systèmes standard. Un logiciel applicatif qui effectue des appels système selon POSIX pourra être utilisé sur tous les systèmes d'exploitation conformes à ce standard[6].

Le système d'exploitation assure la réservation des différentes ressources pour les besoins des programmes exécutés simultanément. Les réservations peuvent être inscrites dans des journaux d'activités à des fins de statistiques ou de dépannage et le système d'exploitation peut refuser une réservation à un utilisateur n'ayant pas reçu d'autorisation[2] préalable.

Le matériel informatique peut exécuter des instructions, celles-ci sont rarement plus que des copies ou des additions. La traduction d'opérations complexes en suite d'instructions est une tâche fastidieuse qui incombe au système d'exploitation[5]. Le système d'exploitation prend en charge toute la manipulation du matériel, le logiciel applicatif ne peut donc pas voir de différence entre une machine simple, rudimentaire et une machine riche et complexe : les mêmes services sont offerts dans les deux cas[1].

Le système d'exploitation facilite le travail de programmation en fournissant une suite de services pouvant être utilisés par les logiciels applicatifs[1]. Du point de vue du programmeur, son logiciel applicatif s'oriente en direction du système d'exploitation et du matériel, et les programmes sont considérés comme fonctionnant sur le système d'exploitation. Un système d'exploitation peut ainsi être vu comme une machine virtuelle. L'ensemble composé du matériel et du système d'exploitation forme la « machine » qui exécute le logiciel applicatif, une machine en partie simulée par du logiciel[1].

Un système d'exploitation est composé d'une large palette de programmes. La composition exacte dépend de l'usage cible et du type d'appareil informatique auquel le système est destiné (ordinateur personnel, serveur, superordinateur ou encore système embarqué).

Utilisation |

Les utilisateurs et les programmeurs peuvent demander des services au système d'exploitation par son interface de programmation, ses commandes ou son interface graphique[7].

- Interface de programmation

Les appels système permettent des interactions entre un programme en cours d'exécution et le système d'exploitation. L'utilisation d'appels système ressemble a celle de fonctions ou de sous-routines ordinaires en langage C ou Pascal[2].

- Commandes

Les commandes permettent à un utilisateur ou un programme de demander une opération au système d'exploitation. Une commande est un programme qui effectue un appel système selon la demande de l'utilisateur[2],[7].

- Interface graphique

L'interface graphique permet une manipulation intuitive par l'intermédiaire de pictogrammes. Cette interface, qui n'est pas une partie essentielle du système d'exploitation, et qui cache tous les détails intrinsèques de celui-ci, est souvent considérée comme un complément[7].

POSIX (acronyme de l'anglais Portable Operating System Interface) est une norme relative à l'interface de programmation du système d'exploitation. De nombreux systèmes d'exploitation sont conformes à cette norme, notamment les membres de la famille Unix.

Processeur |

Lorsqu’il est multitâche, le système d'exploitation permet à plusieurs utilisateurs de se servir de l'ordinateur et donne à chaque utilisateur l'impression qu'il est le seul à utiliser l'ordinateur[5]. Pour ce faire, l'utilisation du processeur est planifiée : chaque programme est exécuté durant une tranche de temps déterminé, puis le système d'exploitation bascule sur l'exécution d'un autre programme[5].

- Processus

Un processus est un ensemble d'instructions qui sont en train d'être exécutées. Les instructions proviennent d'un programme, et l'exécution nécessite du temps, de la mémoire, des fichiers et des périphériques[8]. Le système d'exploitation s'occupe de créer, d'interrompre, et de supprimer des processus. Plusieurs processus se trouvent en mémoire centrale en même temps[7].

La responsabilité du système d'exploitation et de réserver de la mémoire, et de planifier l'exécution, de s'occuper des interblocages[9] et d'assurer les communications entre les processus[8]. L'ordonnanceur (anglais scheduler) associe un processus à un processeur, puis plus tard le dissocie du processeur pour associer un autre processus. cette opération associer / dissocier est appelée context switch[7]. Lors de la planification, le système d'exploitation tient compte de la disponibilité, ou non, des ressources utilisées par le processus[9]. Certains systèmes d'exploitation créent des processus pour effectuer certaines tâches propre au système[6].

Lors de l'exécution du programme, celui-ci peut demander de réserver des ressources de l'ordinateur[6]. L'exécution de ce programme peut être interrompue et le système d'exploitation continue l'exécution d'un autre programme, cependant les ressources restent réservées[6]. Lorsqu'un autre processus demande une ressource déjà réservée, le processus est mis en attente. En situation de forte compétition plusieurs processus peuvent être en attente de la même ressource[6]. Lorsque la ressource est libérée le système d'exploitation décide alors quel est le prochain processus auquel la ressource sera réservée. La stratégie d'octroi des ressources par le système d'exploitation vise à répondre équitablement à toutes les demandes et éviter des conflits[6].

La communication inter-processus |

Dans certains logiciels applicatifs, plusieurs programmes effectuent la même tâche simultanément, et s'échangent des informations[6]. Le mécanisme de protection de la mémoire (voir plus loin) empêche aux programmes de manipuler les mêmes informations, et ceux-ci doivent faire appels à des services du système d'exploitation[6].

- Protection

Par mesure de sécurité, le système d'exploitation réserve à chaque programme un espace d'adressage - un emplacement en mémoire que seul le programme en question peut manipuler[6]. Le système d'exploitation détecte toute tentative d'accès en dehors de l'espace d'adressage et provoque l'arrêt immédiat du programme qui tente d'effectuer telles opérations[6]. On nomme cela une erreur de protection générale.

Mémoire |

Le système d'exploitation dirige l'utilisation de la mémoire. Il retient la liste des emplacements de mémoire utilisés, et par qui, ainsi que la liste des emplacements libres[10]. Le système d'exploitation réserve un emplacement de mémoire lorsqu'un processus le demande, et le libère lorsqu'il n'est plus utilisé, par exemple lorsque le processus s'est arrêté[10].

Les fonctions de contrôle de l'utilisation de la mémoire vont en particulier suivre l'utilisation de celle-ci, quels emplacement sont libres, sont utilisés, et par qui[2]. Ces fonctions vont également décider quel programme reçoit de la mémoire, quand et quelle quantité est mise à disposition et récupérer la mémoire qui était utilisée par un programme après son exécution, que le programme se soit arrêté volontairement ou accidentellement[2].

La quantité de mémoire utilisée par l'ensemble du système informatique dépends essentiellement de la manière dont le système d'exploitation effectue les réservations[8].

Dans les systèmes d'exploitation contemporains, plusieurs programmes sont exécutés en même temps et utilisent simultanément la mémoire centrale[6]. Si un processus modifie - accidentellement ou intentionnellement - un emplacement de mémoire utilisée par un autre processus, il met celui-ci en danger[6]. S'il modifie un emplacement utilisé par le système d'exploitation il met en danger l'ensemble du système informatique[6].

Pour éviter tel incident, le système d'exploitation réserve à chaque programme un espace d'adressage - un emplacement en mémoire que seul le programme en question peut manipuler[6]. Le système d'exploitation détecte toute tentative d'accès en dehors de l'espace d'adressage et provoque l'arrêt immédiat du programme qui tente d'effectuer telles opérations[6], par le biais d'une erreur de protection générale.

La mémoire virtuelle |

Le mécanisme dit de mémoire virtuelle est destiné à simuler la présence ou l'absence de mémoire centrale par manipulation de l'unité de gestion mémoire — un composant électronique (anglais Memory Management Unit abrégé MMU). C'est un mécanisme courant dans les systèmes d'exploitation contemporains.

La mémoire virtuelle permet d'exécuter simultanément plus de programmes que ce que la mémoire centrale peut contenir. Chaque programme n'ayant pas besoin que la totalité des informations qu'il manipule soit présente dans la mémoire centrale[N 1], une partie des informations est stockée dans la mémoire de masse (en général dans un fichier ou une partition de disque dur) habituellement plus importante mais plus lente et sont transférées en mémoire centrale lorsque le programme en a besoin[T 1].

Les programmes disposent d'un (ou plusieurs) espaces virtuels de mémoire continus pour travailler. Les adresses des données sont dites virtuelles dans la mesure où l'information adressée ne se trouve pas forcément ni en mémoire centrale, ni à l'adresse indiquée. Lorsque le programme essaie de lire ou écrire une donnée dans sa mémoire virtuelle, l'unité de gestion de mémoire cherche l'adresse physique correspondant à l'adresse virtuelle sollicitée grâce à une table de correspondance. Si l'emplacement n'est pas présent en mémoire centrale (on appelle cela une faute de page), il n'y aura évidemment aucune adresse physique correspondante. Le système d'exploitation devra alors chercher à libérer un espace en mémoire centrale en échangeant (anglais swap) le contenu d'un emplacement donné de mémoire centrale avec le contenu sollicité, qui se trouve en mémoire de masse[N 2],[T 2]. Cette opération s'effectue automatiquement, à l'insu des programmes.

Des mémoires associatives, incorporées dans l'unité de gestion de mémoire, accélèrent le calcul des adresses[T 3]. Les systèmes d'exploitation utilisent généralement deux mémoires associatives : une pour le mode noyau et une pour le mode utilisateur. La mémoire du mode noyau est arrangée de manière à permettre au processeur d'utiliser la totalité de la mémoire centrale disponible — lors de l'exécution des programmes du noyau du système d'exploitation. Tandis que celle du mode utilisateur est arrangée de manière à protéger le noyau (qui est ainsi invisible pour le programme en question) — lors de l'exécution des programmes hors du noyau. C'est ce que l'on nomme la protection, et ces mécanismes constituent les principales caractéristiques du mode protégé.

Chaque programme dispose de sa propre table de correspondance, ce qui permet de les isoler les uns des autres. Lors d'une commutation de contexte, le système d'exploitation placera la table du programme courant dans la mémoire associative[T 4]. Le système d'exploitation crée également de nouvelles tables pour les programmes qui démarrent et décide quels emplacements de mémoire virtuelle seront ou ne seront pas présents en mémoire centrale[T 5].

Périphériques |

Les périphériques sont tous les dispositifs informatiques qui permettent au processeur de communiquer avec l'extérieur : clavier, imprimante, carte réseau, mémoire, disque dur[6]. Ils permettent en particulier de recevoir des informations, d'en envoyer, ainsi que de stocker des informations - les collecter dans le but de les renvoyer plus tard[6].

Une des responsabilités du système d'exploitation est de suivre l'état d'utilisation - libre ou réservé - de tout le matériel du système informatique. Lorsqu'un matériel libre est demandé par un processus, il est alors réservé à ce processus[9]. Pour utiliser un périphérique, le système d'exploitation se sert d'un contrôleur et d'un pilote de périphérique[9].

- Contrôleur

Un contrôleur est un composant électronique, qui comporte une mémoire tampon, et manipule un certain type de périphérique (disque dur, imprimante, mémoire, lecteur de bande magnétique...)[9]. Le contrôleur est souvent intégré au périphérique[6]. Les différents contrôleurs disponibles sur le marché ne s'utilisent pas tous de la même manière[6].

- Pilote (anglais driver)

Les instructions de manipulation d'une gamme de contrôleurs donnée sont incluses dans un pilote informatique : un logiciel qui exploite les possibilités offertes par les contrôleurs[6]. Les pilotes informatiques font partie du système d'exploitation, et offrent des services uniformes utilisés par les autres programmes du système d'exploitation[6].

Il existe deux stratégies de manipulation des contrôleurs[6] :

- Les contrôleurs rapides sont manipulés en programmed I/O. dans cette stratégie le processeur envoie des demandes d'opérations au contrôleur puis vérifie de manière intermittente l'état du contrôleur pour vérifier si l'opération demandée est terminée[6].

- Les contrôleurs moins rapides sont manipulés en interrupt driven I/O[6]. Dans cette stratégie le processeur effectue une demande au contrôleur, puis continue d'exécuter des logiciels applicatifs. Le contrôleur envoie un signal électrique lorsque l'opération est terminée. Lors de la venue de ce signal, le processeur interrompt l'exécution des logiciels applicatifs et exécute un programme particulier interrupt service routine qui vérifie le nouvel état du contrôleur[6].

Certains périphériques ne peuvent pas être partagés, et leur utilisation est alors dédiée à un seul programme à la fois.

Certains périphériques peuvent être virtuels, ou leur utilisation peut être indirecte. Par exemple l'utilisation d'une imprimante n'entraine pas une impression immédiate parce que les informations sont tout d'abord mises en attente. Cette technique du spool permet l'utilisation partagée d'un périphérique qui sans ça ne pourrait pas être partagé[2].

Fichiers |

Un fichier est une collection d'informations portant un nom, enregistrée sur un média tel qu'un disque dur, une bande magnétique ou un disque optique[8]. Chaque médium a ses propres caractéristiques et sa propre organisation[8].

Le système d'exploitation s'occupe de créer et de détruire des fichiers et des répertoires, de réserver de l'espace sur les médias ainsi que copier le contenu des fichiers de et vers la mémoire centrale[8]. Il aide également les logiciels applicatifs à retrouver les fichiers, partager les fichiers entre plusieurs utilisateurs, modifier le contenu des fichiers et créer des répertoires (permettant de classer et d'organiser les fichiers)[9]. La vitesse du système informatique dépendra de la vitesse de manipulation des fichiers[8].

Le système d'exploitation permet en particulier de manipuler les attributs : les caractéristiques du fichier tels que son nom, la date de création, le type du contenu, la taille et l'emplacement[9]. Il permet également de manipuler les permissions : des autorisations qui indiquent si un utilisateur pourra lire, écrire ou exécuter le fichier[9].

Le système d'exploitation tient compte du système de fichiers : la manière dont les fichiers sont organisés et répartis sur un dispositif de stockage[9].

Les mémoires amovibles telles que les CD ou les DVD ont une disposition normalisée dont les spécifications sont publiques, ce qui assure leur reconnaissance par tous les systèmes d'exploitation (voir ISO 9660 et UDF ainsi que l'hybride ISO/UDF).

Lorsque le système de fichier est distribué, et que les fichiers sont donc stockés sur différents ordinateurs d'un réseau informatique, le système d'exploitation envoie une requête à l'ordinateur stockant le fichier pour chaque opération à effectuer (voir NFS ou CIFS).

Dans un système d'exploitation multi-utilisateurs, les programmes manipulant le système de fichiers effectuent des contrôles pour vérifier qu'aucun fichier n'est manipulé par une personne non autorisée. Ce type de système d'exploitation refusera toute manipulation non autorisée.

Réseau |

Dans un réseau informatique, deux ordinateurs reliés communiquent dès lors que les communications se font de part et d'autre selon les mêmes protocoles réseau. Selon le modèle OSI, les différents protocoles existants sont répartis sur sept niveaux, où un protocole d'un niveau donné peut être combiné avec n'importe quel protocole des niveaux situés en dessus et en dessous (voir encapsulation).

Un système d'exploitation contient typiquement plusieurs programmes nécessaires pour des échanges d'informations dans différents protocoles des niveaux 1 à 4. Tandis que les niveaux 5 à 7 sont pris en charge par les logiciels applicatifs et les middleware.

Pour les échanges d'informations selon les protocoles de niveau 1 et 2, le système d'exploitation demande l'opération au matériel de l'ordinateur par l'intermédiaire d'un pilote informatique, pilote qui peut faire partie intégrante du système d'exploitation ou être fourni par le constructeur du matériel.

Lors de l'envoi d'informations sur le réseau, un logiciel applicatif crée une information, la met en forme conformément aux protocoles des niveaux 7 à 5, puis la transmet au système d'exploitation. Divers programmes du système d'exploitation vont découper cette information en trames, puis vont mettre en forme les trames et les envoyer conformément aux protocoles des niveaux 4 à 1.

Lors de la réception de trames depuis le réseau, divers programmes du système d'exploitation vont tenter de les décoder conformément à différents protocoles des niveaux 1 à 4, puis transformer la suite de trames en un flux continu, qui sera envoyé au logiciel applicatif destinataire. Le logiciel va alors décoder le flux conformément aux protocoles de niveaux 5 à 7. Le logiciel applicatif effectue préalablement une connexion, c'est-à-dire une liaison logique par laquelle il va s'associer avec un flux particulier.

Le choix exact des protocoles utilisés dépend de l'ordinateur concerné et des liaisons réseau qui vont être utilisées. Divers paramètres de configuration permettent d'influencer le choix des protocoles. Ils permettent par exemple d'empêcher l'utilisation de protocoles interdits sur le réseau concerné.

Contrôle d'accès |

Les systèmes d'exploitation contemporains permettent à plusieurs usagers de se servir simultanément de l'ordinateur[8]. Le système d'exploitation comporte des mécanismes destinés à contrôler l'utilisation des ressources par les utilisateurs, les processus et les programmes[8]. Ces mécanismes permettent de certifier l'identité du programme ou de l'utilisateur et lui autoriser l'accès à une ressource en application de règlements de sécurité[8].

Les mécanismes de sécurité du système d'exploitation servent à protéger le système informatique de l'intérieur comme de l'extérieur : les mécanismes de sécurité intérieure protègent les processus les uns des autres, et assurent la fiabilité du système informatique[9]. Les mécanismes de sécurité extérieure protègent les données et les programmes enregistrés dans l'ordinateur contre des accès non autorisés et des erreurs de manipulation[9]. Le système d'exploitation empêche la lecture par des personnes non autorisées, la falsification, la suppression de données, ainsi que l'utilisation non autorisée de périphériques[9].

Plusieurs programmes sont exécutés en même temps et utilisent simultanément la mémoire centrale[6]. Si un processus modifie - accidentellement ou intentionnellement - un emplacement de mémoire utilisée par un autre processus, il met celui-ci en danger[6]. S'il modifie un emplacement utilisé par le système d'exploitation il met en danger l'ensemble du système informatique[6].

Pour éviter tel incident, le système d'exploitation réserve à chaque programme un espace d'adressage - un emplacement en mémoire que seul le programme en question peut manipuler[6]. Le système d'exploitation détecte toute tentative d'accès en dehors de l'espace d'adressage et provoque l'arrêt immédiat du programme qui tente d'effectuer telles opérations[6].

Le système d'exploitation va également refuser la mise hors service de programmes centraux tels que les logiciels serveur ou des programmes du système d'exploitation par tout utilisateur qui n'a pas préalablement reçu le privilège d'effectuer cette opération — selon les règlements introduits par l'administrateur de sécurité.

Lorsqu'un logiciel autonome (bot informatique) demande des opérations au système d'exploitation, le logiciel doit préalablement décliner son identité en tant que produit puis, sur la base de cette identité, le système d'exploitation effectue les mêmes vérifications que pour une personne physique.

Les mécanismes de contrôle d'accès ont aussi pour effet de lutter contre les logiciels malveillants — ceux-ci effectuent souvent des opérations susceptibles de perturber l'utilisation de l'ordinateur.

Interface utilisateur |

Un ensemble de programmes du système d'exploitation reçoit les informations envoyées par les logiciels applicatifs, et les place sur une image numérique qui sera envoyée au matériel par l'intermédiaire d'un pilote. En complément un autre ensemble de programmes reçoit les manipulations effectuées par l'usager par l'intermédiaire de pilotes puis les transmettent au logiciel concerné. Ces deux ensembles créent l'interface homme-machine qui permet à un usager de dialoguer avec la machine.

Le système d'exploitation peut dialoguer avec un usager par l'intermédiaire d'un autre ordinateur ou d'un terminal (interface distribuée). Les informations envoyées par les logiciels applicatifs seront alors envoyées à l'autre ordinateur selon un protocole prévu à cet effet, tandis que l'autre ordinateur enverra les manipulations effectuées par l'utilisateur. Voir SSH, RFB ou X Window System.

Lorsque l'interface est en mode texte, l'image numérique est une grille dans laquelle sont placés des caractères d'imprimerie, la grille comporte typiquement 80 colonnes et 35 lignes. L'interface se manipule avec un clavier. Ce type d'interface, qui existe depuis les débuts de l'informatique[N 3] est aujourd'hui remplacé par les interfaces graphiques.

Interface graphique |

Dans une interface utilisateur graphique (anglais Graphical User Interface abrégé GUI), l'image numérique est composée par un programme du système d'exploitation par superposition de points, de lignes, de pictogrammes et de caractères d'imprimerie. L'interface se manipule typiquement avec une souris selon le principe WIMP (anglais Windows, Icons, Menus and Pointer device). L'image numérique est créée à l'aide du processeur graphique de l'ordinateur.

Lors des manipulations de la souris, le système d'exploitation déplace l'élément d'image qu'est le pointeur et effectue les calculs nécessaires pour déterminer quel est l'élément de l'image qui se trouve juste en dessous. À chaque élément de l'image peut être associé un programme. Un widget est un programme qui dessine et anime un élément d'image dont l'aspect peut-être celui d'un bouton poussoir, d'une lampe témoin, d'un ascenseur, d'une zone texte, d'un menu, etc. Divers widgets sont fournis avec le système d'exploitation.

Les programmes pour interface graphique sont aujourd'hui (2011) inclus dans tous les systèmes d'exploitation contemporains. Le X Window System est l'ensemble des programmes pour interface utilisateur graphique inclus dans tous les systèmes d'exploitation de la famille Unix. Pour Windows, l'équivalent est le programme Explorer, aussi nommé Explorateur Windows (à ne pas confondre avec Internet Explorer).

Logiciels utilitaires |

Un logiciel applicatif sert à assister l'utilisateur dans une activité. Les logiciels utilitaires sont des logiciels applicatifs qui permettent à l'utilisateur d'effectuer des manipulations basiques telles que démarrer des programmes, copier des fichiers ou modifier des paramètres de configuration. Divers logiciels utilitaires sont fournis avec les systèmes d'exploitation.

Un interpréteur de commandes est un programme qui permet d'exécuter d'autres programmes en écrivant leur nom éventuellement suivi de divers paramètres. Il est accompagné de plusieurs programmes qui permettent la manipulation des fichiers (copie, changement de nom…). Ce type de programme est utilisé pour effectuer des manipulations ou exécuter des scripts — suites de manipulations pré-enregistrées (voir commande informatique). Ce type de programme est souvent fourni avec le système d'exploitation, mais rien n'y oblige, et on peut très bien en importer.

Un environnement de bureau est un programme dans lequel les différents éléments de l'ordinateur (programmes, fichiers, disques durs) sont présentés sous forme de pictogrammes sur lesquels il est possible d'effectuer différentes actions. Il permet d'exécuter des programmes, d'effectuer différentes opérations sur les fichiers (copie, changement du nom, déplacement ou suppression).

Certains programmes permettent à l'utilisateur de modifier les paramètres de configuration du système d'exploitation. Ceux-ci proposent des listes à choix multiples et effectuent des contrôles de validité avant le modifier les paramètres.

D'autres programmes servent à installer des logiciels, c'est-à-dire copier les fichiers dans les emplacements prévus à cet effet, et effectuer les modifications de configuration nécessaire pour rendre le logiciel opérationnel. Ces programmes peuvent aussi servir à consulter la liste des logiciels actuellement installés dans l'ordinateur.

Un système d'exploitation multi-utilisateurs est en général fourni avec des programmes permettant de surveiller l'utilisation — par autrui — de l'ordinateur — consultation de journaux d'activité — ou de modifier les listes de droits d'accès en vue d'autoriser ou d'interdire un fichier à certains utilisateurs.

Typologie |

Il existe cinq générations de systèmes d'exploitation : par lots (batch), multi programmés, en temps partagé, temps réel, et distribués. Chacun des principes mis en œuvre dans une génération se retrouve dans les générations suivantes[5].

- Un système de traitement par lots (batch) est prévu pour l'exécution de grands calculs les uns après les autres, avec peu d'intervention utilisateur[2].

À partir de la génération des systèmes d'exploitation multi-programmés, plusieurs programmes sont exécutés simultanément par planification (scheduling). Dans ces systèmes d'exploitation multitâches, plusieurs programmes résident dans la mémoire centrale et le système d'exploitation suspend régulièrement l'exécution d'un programme pour continuer l'exécution d'un autre[5].

- Dans la génération des systèmes multi-programmés, l'exécution simultanée de plusieurs programmes vise l'utilisation efficace de la puissance de calcul du processeur.

- Dans la génération des systèmes en temps partagé l'exécution simultanée de plusieurs programmes vise à répondre rapidement aux demandes de plusieurs utilisateurs en communication directe avec l'ordinateur[5].

- Un système d'exploitation temps réel doit garantir que toute opération se termine dans un délai donné, en vue de garantir la réussite du dispositif dans lequel l'ordinateur est utilisé[2].

- Un système distribué dirige l'utilisation des ressources de plusieurs ordinateurs à la fois. Il utilise les capacités d'un réseau informatique, contrôle un groupe de machines, et les fait apparaître comme une machine unique, virtuelle, de très grande capacité[2].

Chaque système d'exploitation est conçu pour fonctionner avec une gamme particulière de machines (type de processeur, constructeur, architecture). Si un système d'exploitation est disponible pour plusieurs gammes de machines différentes, alors le même code source est compilé[N 4] et adapté à chaque gamme de machines. La palette de pilotes inclus dans le système d'exploitation est adaptée au matériel informatique disponible sur le marché pour cette gamme de machines.

Première génération : Traitement par lots |

Les systèmes d'exploitation basés sur le traitement par « lots » (suites d'instructions et de données dans un ensemble de cartes perforées) sont apparus dans les années 1950. Un programme (avec ses données) n'est rien d'autre qu'une pile de cartes avec des indicateurs de début et de fin de lot. L'exécution d'un programme consiste à demander à un opérateur de placer la pile de cartes dans le lecteur, puis l'opérateur lance la lecture séquentielle des cartes. Le processeur central est au repos, durant les manipulations de l'opérateur[5].

Un batch est un lot de travaux à effectuer. L'opérateur compose un batch en posant les unes sur les autres les piles de cartes des différents programmes (avec leurs données) demandés par les utilisateurs. Il forme une grande pile de cartes séparées par des marque-page, en général une carte de couleur particulière, qu'il place ensuite dans le lecteur. Le regroupement de plusieurs programmes en un batch diminue les interventions de l'opérateur[5].

Dans un système basé sur les batchs, le cœur du système d'exploitation est un programme moniteur qui réside continuellement en mémoire centrale et permet à l'opérateur de demander le début ou l'arrêt de l'exécution du lot. À la fin de l'exécution de chaque tâche du lot, le moniteur effectue des travaux de nettoyage, puis lance l'exécution de la tâche suivante. Ainsi, l'opérateur intervient uniquement au début et à la fin du lot[5].

Dans ces systèmes d'exploitation les commandes ajoutées au marque-page, formulées dans le langage JCL (Job Control Language) sont un des seuls moyens qu'a l'utilisateur d'interagir avec le système d'exploitation[5].

Les systèmes d'exploitation batch sont adaptés à des applications nécessitant de très gros calculs mais peu d'implication de l'utilisateur : météo, statistiques, impôts... Les utilisateurs n'attendent pas immédiatement de résultats. Ils soumettent les demandes, puis reviennent ultérieurement collecter les résultats[5].

En raison de la grande différence de vitesse entre le processeur et les périphériques, dans un système d'exploitation batch le processeur est inutilisé 90 % du temps car les programmes attendent qu'un périphérique ou un autre termine les opérations. Avec ces systèmes d'exploitation il n'y a pas de concurrence entre les différentes tâches, la mise en œuvre de l'utilisation du processeur, de la mémoire et des périphériques est triviale[5] mais loin d’être optimale.

Deuxième génération : la multiprogrammation |

Les systèmes d'exploitation multi-programmés sont apparus dans les années 1960. Le but recherché par de tels systèmes est d'augmenter l'efficacité de l'utilisation du processeur et des périphériques en utilisant la possibilité de les faire fonctionner en parallèle. Plusieurs programmes sont placés en mémoire centrale, et lorsque le programme en cours d'exécution attend un résultat de la part d'un périphérique, le système d'exploitation ordonne au processeur d'exécuter un autre programme[5].

Dans les systèmes d'exploitation multi-programmés, l'utilisation du processeur est partagée par planification (scheduling) : à chaque utilisation d'un périphérique, le système d'exploitation choisit quel programme va être exécuté. Ce choix se fait sur la base de priorités. Le système d'exploitation comporte un mécanisme de protection évitant ainsi que le programme en cours d'exécution ne lise ou n'écrive dans la mémoire attribuée à un autre programme. Les programmes sont exécutés dans un mode non-privilégié, dans lequel l'exécution de certaines instructions est interdite[5].

Les systèmes multi-programmés nécessitent un ordinateur et des périphériques mettant en œuvre la technique du DMA (direct memory access) celle-ci, le processeur ordonne à un périphérique d'effectuer une opération, le résultat de l'opération est placé en mémoire centrale par le périphérique tandis que le processeur exécute d'autres instructions. Dans les systèmes multi-programmés, tout comme pour les systèmes batch, l'utilisateur n'a que peu de contact avec les programmes et de maigres possibilités d'intervention[5].

Troisième génération : le temps partagé |

Les systèmes d'exploitation en temps partagé sont apparus dans les années 1970. Ils sont utilisés dans des dispositifs interactifs où plusieurs utilisateurs sont simultanément en dialogue avec l'ordinateur. Un système d'exploitation en temps partagé est destiné à répondre rapidement aux demandes de l'utilisateur, et donner à chaque utilisateur l'impression qu'il est le seul à utiliser l'ordinateur[5].

Un système en temps partagé met en œuvre des techniques sophistiquées de multiprogrammation en vue de permettre l'utilisation interactive de l'ordinateur par plusieurs usagers et plusieurs programmes simultanément[2]. L'arrivée, en 1970, de cette nouvelle génération de systèmes d'exploitation résulte d'une forte demande des consommateurs, et de la baisse du prix du matériel informatique ayant rendu possible sa réalisation[5].

Dans les systèmes d'exploitation en temps partagé la notion de batch n'a que peu d'importance. Ces systèmes mettent en œuvre de nouveaux mécanismes d'utilisation du processeur et de la mémoire, qui leur permet de répondre rapidement à des demandes provenant simultanément d'un grand nombre d'utilisateurs[5].

Dans ces systèmes, tout comme dans la génération précédente, l'utilisation du processeur est planifiée. Cependant, contrairement aux systèmes de la génération précédente, dans les systèmes en temps partagé chaque programme est exécuté durant une tranche de temps déterminé, puis le système d'exploitation bascule sur l'exécution d'un autre programme, ce qui évite qu'un programme monopolise l'utilisation du processeur au service d'un utilisateur, entraînant des retards pour les autres usagers[5].

Les systèmes d'exploitation en temps partagé mettent en œuvre la technique du swap : lorsque le programme en cours d'exécution a besoin de plus de mémoire que celle disponible, un autre programme inactif est retiré pour gagner de la place, le programme inactif est alors enregistré temporairement sur le disque dur. L'enregistrement sur disque provoque cependant une perte de temps non négligeable[5].

En 2011 de nombreux systèmes d'exploitation sont basés sur Unix, un système en temps partagé[3].

Quatrième génération : le temps réel |

Les systèmes d'exploitation temps-réel sont apparus au milieu des années 1970, notamment chez Hewlett-Packard[11]. Ils sont destinés aux dispositifs devant non seulement donner des résultats corrects, mais les donner dans un délai déterminé. Ces systèmes d'exploitation sont souvent utilisés par des ordinateurs reliés à un appareil externe (pilotes automatiques, robots industriels, applications vidéo et audio[5]) pour lequel un retard de réponse de l'ordinateur entraînerait un échec de l'appareil.

Dans ces systèmes d'exploitation, l'accent est mis sur la durée nécessaire pour effectuer chaque opération, pour répondre aux demandes rapidement en vue de satisfaire aux contraintes de temps du système dans lequel il est utilisé[5].

Certains services offerts par ces systèmes d'exploitation sont réalisés comme des logiciels applicatifs, et sont exécutés en concurrence avec ceux-ci. Un système d'exploitation temps réel autorise un contact direct entre les logiciels applicatifs et les périphériques. Dans certains systèmes temps réel les ressources sont réservées, évitant ainsi les ralentissements que provoqueraient les réservations à la volée, et garantissant que les ressources sont continuellement disponibles[5].

Les systèmes d'exploitation temps-réel évitent d'utiliser la technique du swap en raison des risques de dépassement des délais[5].

RTX, Windows CE, Embedded Linux, Symbian OS, Palm OS et VxWorks sont des systèmes d'exploitation temps réel[12].

Cinquième génération : les systèmes distribués |

La baisse des prix du matériel informatique a permis, dans les années 1990, la création de systèmes informatiques composés de plusieurs ordinateurs, et donc plusieurs processeurs, plusieurs mémoires, et de nombreux périphériques. Un système distribué permet le partage des ressources entre les ordinateurs. Un utilisateur d'un ordinateur bon marché peut se servir de ressources coûteuses existant sur un autre ordinateur[5].

Mach, Amoeba, Andrew, Athena, et Locus sont des systèmes d'exploitation distribués. Ils ont tous été développés par des universités[13].

Histoire |

L'histoire des systèmes d'exploitation est fortement liée à celle des ordinateurs. Les premières générations d'ordinateurs, dans les années 1945 à 1955, ne comportaient pas de système d'exploitation. Dans ces ordinateurs équipés de tubes à vide, les programmes manipulaient les ressources matérielles de l'ordinateur sans passer par un intermédiaire[14]. L'ordinateur était utilisé par une seule personne à la fois : la tâche de l'opérateur consistait à placer des piles de cartes perforées dans le lecteur, où chaque carte comportait des instructions d'un programme ou des données[14]. Les ordinateurs à tube à vide de cette génération n'avaient qu'une faible puissance de calcul, ils étaient volumineux, peu commodes et peu fiables (les tubes à vide grillaient souvent)[14].

1960, la multiprogrammation |

Dans les années 1960, avec l'arrivée des circuits électroniques à semi-conducteurs, la puissance de calcul des processeurs a augmenté de manière significative[14]. Cela a permis la réalisation de systèmes d'exploitation rudimentaires : les ordinateurs ont été équipés d'un spooler - file d'attente permettant d'utiliser la puissance de calcul du processeur pendant que l'opérateur introduit les cartes. L'utilisation des ressources matérielles par les programmes se faisaient alors par l'intermédiaire d'une bibliothèque logicielle[14]. Il a alors été possible de placer en mémoire plusieurs programmes simultanément et de les exécuter simultanément ; un programme dit resident monitor résidait continuellement dans la mémoire centrale et contrôlait l'exécution des différents programmes[14].

En 1965 le Massachusetts Institute of Technology se lance dans la création du premier système d'exploitation multitâche et multi-utilisateurs : Multics (pour MULTiplexed Information and Computing Service[T 6], ou service multiplexé d'information et de calcul). Sur le principe de la multiprogrammation, le système d'exploitation autorisait le chargement de plusieurs programmes en mémoire et gérait le passage de l'un à l'autre, mais cette fois-ci sans attendre le blocage d'un programme[N 5]. Chaque programme était exécuté pendant une durée de quelques millisecondes, puis le système passait au suivant. Ce temps, très court, donnait l'illusion que les programmes s'exécutaient simultanément — une illusion qui existe encore avec les systèmes d'exploitation contemporains.

De plus, ces programmes pouvaient appartenir à des utilisateurs distincts, chacun ayant l'impression que la machine travaille uniquement pour lui. La possibilité pour un ordinateur de servir simultanément plusieurs personnes augmentait le retour sur investissement de l'achat de matériel très coûteux par les entreprises et les institutions. Cependant, du fait de son écriture dans un langage de programmation PL/I trop complexe pour les ordinateurs de l'époque, Multics fut un échec commercial. Il a cependant inspiré en grande partie la gamme de systèmes GCOS développés conjointement par Honeywell et Bull[15].

En 1969, les ingénieurs Ken Thompson et Dennis Ritchie des laboratoires Bell rêvent d'utiliser le système d'exploitation Multics, mais le matériel pour le faire fonctionner est encore hors de prix. Thompson se lance dans l'écriture d'une version allégée de Multics pour un PDP-7 inutilisé. Le système, fonctionnel, est surnommé Unics (pour UNiplexed Information and Computing Service[T 7]), puis finalement baptisé UNIX. Rapidement reprogrammé dans un langage de programmation plus approprié (le C, développé par Ritchie pour l'occasion), UNIX se révèle particulièrement simple à porter sur de nouvelles plateformes, ce qui assure son succès[T 8],[16].

1972, les micro-ordinateurs |

Dès 1980, les circuits électroniques à transistor ont été remplacés par des circuits intégrés, plus petits, ce qui a permis de réaliser des appareils plus compacts et moins coûteux et lancé le marché des ordinateurs personnels. De nombreux concepteurs de système d'exploitation qui se sont lancés sur ce marché n'avaient pas d'expérience, ce qui a donné de nouveaux produits, fondés sur des nouvelles idées, sans héritage ou influence de ce qui se faisait jusqu'alors[14]. CP/M, mis sur le marché en 1974, a été le premier système d'exploitation pour micro-ordinateur, son caractère très sympathique, facile à aborder et commode (user-friendly) l'a rendu très populaire et influencé le marché des systèmes d'exploitation[14].

En 1980, IBM prend contact avec Bill Gates, cofondateur de la société Microsoft, pour l'adaptation du langage BASIC à son nouveau micro-ordinateur : le Personal Computer (abrégé PC). IBM est également à la recherche d'un système d'exploitation, et Bill Gates leur conseille de se tourner vers CP/M. Mais Gary Kildall refuse de signer le contrat avec IBM. Bill Gates saute sur l'occasion : il rachète QDOS — un système d'exploitation quick-and-dirty pour les processeurs Intel 8086 — pour proposer à IBM le package DOS/BASIC. Après quelques modifications effectuées à la demande d'IBM, le système est baptisé MS-DOS[T 9],[17].

Xerox, une des sociétés majeures de l'époque, s'intéresse à l'optique de Steve Jobs. Elle réunit une poignée de scientifiques et d'ingénieurs dans son centre de recherche de Palo Alto et développe le premier micro-ordinateur équipé d'une interface utilisateur graphique, sur la base de thèses et d'études en ergonomie effectuées les années précédentes. Le résultat de ces recherches, le Xerox Star, ne sera jamais commercialisé. Dix ans plus tard, c'est Apple avec le Macintosh qui popularise les recherches effectuées par Xerox[18].

1990, les systèmes d'exploitation sous licence libre |

En 1983, Richard Stallman du Massachusetts Institute of Technology lance l'idée d'un système d'exploitation sous licence libre : GNU[19]. Il développe des outils de programmation, des logiciels utilitaires, et crée la GNU General Public License — un contrat de licence autorisant une utilisation sans restrictions ainsi que la publication du code source, sa modification, et sa redistribution. Le succès est immédiat, mais le système ne possède toujours pas, en 1990, de noyau libre, et les tentatives pour en développer un sont loin d'être abouties[20].

En 1987, Andrew Tanenbaum, professeur à l'université libre d'Amsterdam créé le système d'exploitation Minix, clone d'UNIX dont le code source est destiné à illustrer son cours sur la construction des systèmes d'exploitation[N 6]. Mais Minix, dont la vocation est pédagogique, comporte alors de trop nombreuses limitations techniques et ne permet pas une utilisation poussée[N 7].

En 1991, Linus Torvalds, étudiant à l'université d'Helsinki, inspiré par les travaux de Tanenbaum, sort la toute première version (0.01) de son propre noyau : Linux, qui est au départ une réécriture de Minix. Linux passe sous licence GNU en 1992[21] et il faut attendre 1994 pour voir la version 1.0[T 10], donnant ainsi naissance à la distribution d'un système d'exploitation entièrement libre, GNU/Linux.

Un autre système d'exploitation libre apparaît à la même époque : 4.4BSD. La Berkeley Software Distribution (BSD) est la version d'UNIX développée par les étudiants et les chercheurs de l'université de Berkeley depuis 1977[22]. Les logiciels utilitaires, créés sous licence libre, sont vendus avec le noyau Unix de AT&T, lui-même sous licence propriétaire. Cette double licence de BSD est à l'origine de plusieurs années de litige entre l'Université de Berkeley et AT&T[23]. Les étudiants de l'université travaillent à remplacer les programmes développés par AT&T par leurs propres programmes, sous licence libre, afin de résoudre le litige. Cette situation dure jusqu'à la sortie de 4.4BSD en 1994, qui ne contient pratiquement plus de code AT&T[T 11].

C'est à la suite des initiatives et travaux de Linus Torvalds et de Richard Stallman, aidés par des milliers de bénévoles, et consécutivement aux travaux des étudiants de l'université de Berkeley que GNU/Linux et 4.4BSD sont devenus les premiers systèmes d'exploitation sous licence libre[24].

Organisation générale du noyau |

Comparaison entre noyau monolithique ou micronoyau.

Un système d'exploitation est essentiellement événementiel - il est exécuté lorsque quelque chose s'est passé, typiquement lors d'un appel système, une interruption matérielle ou une erreur[25]. C'est un logiciel étendu et complexe, qui offre de nombreuses fonctions. Il est construit comme une suite de modules, chacun ayant une fonction déterminée[26].

Le noyau (en anglais : kernel) est la pièce centrale du système d'exploitation[27]. C'est le second programme chargé en mémoire (juste après le bootloader) et il y reste en permanence - ses services sont utilisés continuellement[27].

Il réside généralement dans un emplacement protégé de mémoire vive, qui ne peut pas être modifié ni exploité par les autres programmes[27] (c'est-à-dire dans le cas d'un système d'exploitation en mode protégé).

C'est un composant critique : si le kernel subit une erreur et s'arrête alors l'ordinateur cessera de fonctionner, tandis que si un autre programme s'arrêtait (par exemple un programme utilisateur) alors le système d'exploitation resterait opérationnel[27].

Il offre typiquement des fonctions pour créer ou détruire des processus (i.e. exécuter des programmes), diriger l'utilisation du processeur, de la mémoire et des périphériques. Il offre également les fonctions qui permettent aux programmes de communiquer entre eux et de s'aligner dans le temps (synchronisation)[26].

Noyau monolithique |

Dans une construction monolithique, le système d'exploitation est composé d'un seul programme : le noyau. Celui-ci est typiquement organisé en couches[28]. La construction monolithique est la plus courante, appliquée à la plupart des Unix[27].

Noyau à micronoyau |

Dans la construction micronoyau, le kernel fournit les services minimum[27] : de nombreuses fonctions du système d'exploitation ont été retirées du noyau et sont offertes par des programmes manipulés par celui-ci, qui sont ce que l'on appelle des services[28] (pour un système en mode protégé, la grande différence avec un système monolithique sera que ces services seront exécutés dans l'espace mémoire utilisateur et non celui du noyau).

Les appels de fonction au système d'exploitation par les programmes utilisateurs ont été remplacées par des envois de message[28]. Dans cette construction le noyau est utilisé principalement pour planifier l'exécution de processus, et pour échanger des messages[28]. AIX, BeOS, Mach, Hurd, MacOS X, Minix et QNX sont des systèmes d'exploitation qui utilisent cette construction[27].

Noyau hybride |

La construction hybride ressemble à une construction microkernel, cependant certaines fonctions ont été placées dans le noyau pour des raisons d'efficacité[27]. Windows NT, 2000 et XP (et également les Windows plus récents) ainsi que DragonFly BSD sont en construction hybride[27].

Système organisé par couches |

Le principe de la répartition par couches est que chaque module d'une couche donnée utilise uniquement des fonctions offertes par les modules qui se trouvent dans la couche au-dessous[26]. L'organisation en couche n'est pas unique aux systèmes d'exploitation et est couramment appliquée aux logiciels applicatifs[28]. Dans un système d'exploitation, les couche inférieures concernent les périphériques et la mémoire ; au-dessus desquelles se trouvent les systèmes de fichiers, puis les processus[28]. Ces couches constituent la normalisation de la machine : pour un programme utilisateur et un système d'exploitation donné, tous les ordinateurs seront identiques (ou presque). C'est ce que l'on nomme l'abstraction materielle[29]

Appels système |

Le kernel étant dans un emplacement protégé, il est impossible pour un logiciel applicatif d'appeler directement ses fonctions[27]. Un mécanisme permet aux logiciels applicatifs de demander des services au système d'exploitation[28]. Il est typiquement mis en œuvre par une bibliothèque. Celle-ci comporte des fonctions bouchon qui consistent à placer les paramètres selon une convention, puis utiliser une instruction du processeur qui provoque la mise en pause du processus en cours et l'exécution du système d'exploitation[28]. Les fonctions de bouchon s'utilisent comme les fonctions ordinaires d'une bibliothèque[28].

Noyau client-serveur |

Dans une construction client-serveur, le cœur du système d'exploitation a pour seule fonction d'assurer la communication entre les modules[26]. Le système d'exploitation est divisé en nombreux petits modules qui sont exécutés de la même manière que des logiciels applicatifs. Cette construction est bien adaptée aux systèmes d'exploitation distribués[26].

Principe de machine virtuelle |

Le principe des machines virtuelles, est que le système d'exploitation crée l'illusion qu'il existe plusieurs machines, aux capacités étendues, en utilisant une seule machine aux capacités plus limitées[26]. Le cœur du système d'exploitation est un moniteur qui crée les illusions - machine virtuelle -. Les caractéristiques techniques de ces machines virtuelles sont identiques à celle de la machine réellement utilisée et celles-ci peuvent être utilisées pour exécuter un autre système d'exploitation[26].

Quelques exemples |

| Année d'apparition | Nom | Famille | Éditeur | Matériel pris en charge | Utilisation | Noyau | Graphique | Multitâche | Multi-utilisateur | Multiprocesseur | Temps réel |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 1973 | SYSMIC | R2E | Micral | ordinateurs personnels, stations de travail | |||||||

| 1977 | VMS | DEC | VAX, DEC Alpha, Hewlett-Packard | serveurs, ordinateurs centraux | |||||||

| 1978-1985 | CP/M | Digital Research | Amstrad CPC, Commodore 128, TRS-80 | ordinateurs personnels | |||||||

| 1981-1990 | DOS | IBM & Microsoft | Compatible PC | ordinateurs personnels | |||||||

| 1982 | QNX | Quantum Software Systems | compatibles PC, MIPS, PowerPC, ARM | systèmes embarqués, automates industriels | |||||||

| 1984 | Mac OS | Apple | Apple Macintosh | ordinateurs personnels | |||||||

| 1985 | TOS | Atari | Atari ST, Eagle, Medusa, Hades, Milan, Firebee, ColdFire | ordinateurs personnels | |||||||

| 1985 | AmigaOS | Commodore | Commodore Amiga, PowerPC | ordinateurs personnels et consoles de jeu | |||||||

| 1986 | AIX | Unix | IBM | PS/2, RS/6000, PowerPC | ordinateurs personnels, serveurs, stations de travail, superordinateurs | ||||||

| 1986 | Irix | Unix | SGI | machines de SGI | stations de travail et serveurs | ||||||

| 1986-1996 | NeXTSTEP | Unix | NeXT | Compatible PC, SPARC, Hewlett-Packard | stations de travail | ||||||

| 1987-2006 | OS/2 | IBM et Microsoft | PS/2 et Compatible PC | ordinateurs personnels | |||||||

| 1987 | Minix | Andrew Tanenbaum | Compatible PC, m68k, SPARC | (pédagogique)[N 8] | |||||||

| 1989 | Symbian OS[N 9] | Symbian ltd[N 10] | Nokia, Siemens, Samsung, Panasonic | téléphones mobiles, smartphone, assistants personnel | |||||||

| 1990 | Windows 3.x | Windows | Microsoft | Surcouche logicielle à DOS | ordinateurs personnels | ||||||

| 1991 | Solaris | Unix | Sun | machines de Sun et x86/64 | serveurs, stations de travail, superordinateurs | ||||||

| 1991 | GNU/Linux | Unix | (communautaire) | nombreux[N 11] | tous | ||||||

| 1991[N 13] | Windows NT | Windows | Microsoft | Compatible PC | serveurs, stations de travail, ordinateurs personnels | ||||||

| 1994[N 14] | NetBSD | Unix | (communautaire) | nombreux[N 15] | tous | ||||||

| 1994[N 14] | FreeBSD | Unix | (communautaire) | nombreux[N 16] | tous | ||||||

| 1994[N 14] | OpenBSD | Unix | (communautaire) | nombreux[N 17] | tous | ||||||

| 1996 | Windows CE | Windows | Microsoft | x86, MIPS, ARM[35] | smartphone, assistants personnels, automates industriels | ||||||

| 1996 | RTX | Intervalzero | x86, x64[37] | ordinateurs industriels | |||||||

| 1999[N 18] | Mac OS X | Unix | Apple | x86, PowerPC de Apple | ordinateurs personnels, serveurs, station de travail | ||||||

| 1999 | BlackBerry OS | Research In Motion | téléphones mobiles de BlackBerry | smartphone | ?? | ?? | |||||

| 2007 | Android | Unix | consortium Open Handset Alliance | produits des fabricants du Open Handset Alliance | smartphone, tablette électronique | ?? | ?? | ||||

| 2007 | iOS | Unix | Apple | appareils de Apple (iPhone, iPod, iPad...) | smartphone, tablette électronique, baladeur numérique | ?? | |||||

| 2007 | Sailfish OS | Unix | Jolla | appareils de la firme Finlandaise Jolla | smartphone, tablette électronique | ?? |

Le marché |

Parts des systèmes d'exploitation des PC en 2014 dans le monde[38].

Parts des systèmes d'exploitation des smartphones en 2011 dans le monde.

Née en 1985, la gamme des systèmes Windows de Microsoft équipe en 2008 près de 90 % des ordinateurs personnels, ce qui la place en situation de monopole notamment auprès du grand public. En 2008, ses parts de marché sont descendues en dessous de 90 % pour la première fois depuis 15 ans[39]. Puis à la suite de la croissance très rapide du marché des smartphones, et du retard pris par Microsoft sur ce marché, ses parts de marché sur les appareils personnels sont passées de 95 % en 2005 à 20 % en 2013[40].

Amorcée en 1969, la famille de systèmes d'exploitation Unix compte plus de 25 membres[41]. GNU/Linux, BSD et Mac OS X sont aujourd'hui les systèmes d'exploitation les plus populaires de la famille Unix.

La famille Windows équipe aujourd'hui 38 % des serveurs tandis que la famille Unix équipe 31 %, dont à peu près la moitié avec GNU/Linux[42]. La famille Unix anime 60 % des sites web dans le monde[43] et GNU/Linux équipe 95 % des près de 500 superordinateurs du monde[44]. En 2012, la famille Unix anime 90 % des smartphones[réf. nécessaire].

Né en 1990, Symbian OS est en 2007 le système d'exploitation le plus répandu sur les téléphones mobiles et assistants personnels, avec 67 % de part de marché[45]. En 2012, les quatre systèmes d'exploitation Android de Google, Symbian, iOS de Apple et Blackberry de Research In Motion occupent ensemble 95 % du marché des smartphones. Android, le plus populaire (75 %), est en progression, tandis que les autres sont en recul. Les parts de marché de Symbian ne sont plus que de 2,3 %[46].

Du côté des tablettes tactiles, iOS de Apple était le premier système d'exploitation largement diffusé avec plus de 80 % de part de marché en 2010[47]. Trois ans plus tard sa part de marché est de 20 % et celle de Android est de plus de 56 %[48].

Les serveurs et super-ordinateurs sont majoritairement équipés de systèmes d'exploitation de la famille UNIX[49].

Choix par l'acheteur |

De nombreux logiciels applicatifs sur le marché sont construits pour fonctionner avec un système d'exploitation en particulier, ou une famille en particulier et un système d'exploitation est construit pour fonctionner avec une gamme de machines donnée. Pour l'acheteur le choix de la famille de machine limite le choix du système d'exploitation, qui lui-même limite le choix des logiciels applicatifs.

Chaque système d'exploitation, selon la palette de programmes qu'il contient, est construit pour fonctionner avec certains réseaux informatiques. Pour l'acheteur qui possède un réseau informatique (typiquement les entreprises et les institutions) le choix du système d'exploitation dépend de son adéquation au réseau existant de l'acheteur.

L'utilité d'un système d'exploitation pour l'usager est proportionnel au nombre de logiciels applicatifs qui sont prévus pour lui. La popularité élevée d'un système d'exploitation attire les éditeurs de logiciels applicatifs, ce qui accroit encore sa popularité (effet réseau). Ce phénomène fait que le marché est sujet aux situations de monopole.

Apple, Sun Microsystems et Silicon Graphics sont des marques qui fabriquent du matériel informatique et développent des systèmes d'exploitation pour leur propre matériel. Certains systèmes d'exploitation, comme Microsoft Windows et Android, sont vendus avec le matériel informatique, conformément à des accords entre les fabricants.

Concurrence, compatibilité et interopérabilité |

Cette section ne cite pas suffisamment ses sources (janvier 2017). Pour l'améliorer, ajoutez des références vérifiables [comment faire ?] ou le modèle {{Référence nécessaire}} sur les passages nécessitant une source. |

La compatibilité d'un système d'exploitation est sa capacité à être utilisé à la place d'un autre, en particulier à exécuter les logiciels applicatifs de l'autre. Le système d'exploitation est dit « compatible » avec l'autre. La compatibilité au niveau source est la capacité pour un système d'exploitation A d'exécuter un logiciel applicatif créé pour B après avoir compilé le code source du logiciel pour la machine A. Et la compatibilité binaire est la capacité pour un système d'exploitation A d'exécuter un logiciel applicatif créé pour B tel quel, sans avoir à le recompiler.

L’interopérabilité est la capacité pour plusieurs systèmes à être utilisés ensemble, par exemple dans un même appareil, ou dans un réseau informatique.

Pour être compatibles, deux systèmes d'exploitation doivent avoir des points communs, notamment sur l'interface de programmation. La compatibilité binaire n'est possible qu'entre deux systèmes d'exploitation qui fonctionnent avec la même famille de processeur.

La compatibilité et l'interopérabilité entre les systèmes d'exploitation sont assurées, par les éditeurs, par alignement de leur produit sur des normes industrielles ainsi que des technologies rendues publiques.

Le système d'exploitation Unix, créé en 1969, a servi de source d'inspiration pour toute une famille de systèmes d'exploitation. Le jeu de la concurrence, très vif dans les années 1980, a conduit les différents membres de la famille Unix à s'éloigner, et perdre la compatibilité les uns avec les autres. Des organismes de normalisation tels que Open Group se sont penchés sur le problème et ont édicté des normes garantissant la compatibilité à travers toute la famille Unix.

Entre 1995 et 2007, Microsoft, éditeur de la suite de systèmes d'exploitation Windows a été l'objet de plusieurs procès pour des pratiques anticoncurrentielles nuisant à la concurrence et à l'interopérabilité. La société a été condamnée par le département de la justice des États-Unis pour violation du Sherman Antitrust Act, ainsi que par la Commission européenne pour violation des traités relatifs à la concurrence dans l'Union européenne.

La popularisation d'Internet dans les années 1990 a contribué à améliorer l'interopérabilité entre les systèmes d'exploitation.

La guerre des Unix et l'Open Group |

Le système d'exploitation Unix a été développé par American Telephone & Telegraph (AT&T). Jusqu'en 1975, un accord avec l'État fédéral américain lui interdisait de commercialiser Unix, ayant le monopole de la téléphonie aux États-Unis, le code source du système d'exploitation était par conséquent public. Mais en 1975, ce monopole fut attaqué en justice et en 1982, la société était démembrée par décision de justice. AT&T, née de la fragmentation des activités d’American Telephone & Telegraph, put enfin commercialiser Unix : les ingénieurs de la société partirent du code source de la version 7 (ouverte) pour aboutir à UNIX System V. Simultanément, d'autres éditeurs s'inspirèrent de la version 7 pour créer des systèmes Unix, notamment l'université de Berkeley, avec sa Berkeley Software Distribution[50] (BSD, 1979). Puis ceux-ci ont servi de source d'inspiration pour d'autres systèmes d'exploitation, et ainsi de suite. En 2009, la famille Unix comptait plus de 25 systèmes d'exploitation.

Le jeu de la concurrence a conduit chaque éditeur à ajouter ses propres améliorations et ses propres fonctionnalités à son système d'exploitation optimisé pour un matériel en particulier. Ceci a amené les différents membres de la famille Unix à s'éloigner, et perdre la compatibilité l'un avec l'autre.

En 1987, dans le but de réunifier la famille Unix, AT&T conclut un accord avec Sun Microsystems (un des principaux éditeurs de système d'exploitation fondé sur BSD). Les autres éditeurs ne voyant pas cet accord d'un bon œil, créent la fondation Open Software Foundation (OSF). Dans un même temps, l'Open Group, un consortium de normalisation, publie des normes relatives aux systèmes d'exploitation de la famille Unix[51]. Les deux institutions sont aujourd'hui fusionnées.

POSIX est le nom donné aux normes IEEE 1003. Cette famille de normes appartenant à l'Open Group a été lancée en 1988 et concerne l'interface de programmation. La conformité d'un système d'exploitation à cette norme assure la compatibilité au niveau source. En 2009, de nombreux systèmes d'exploitations sont conformes à cette norme, y compris en dehors de la famille Unix[52].

POSIX fait partie de la Single Unix Specification, une norme lancée en 1994 par l'Open Group, qui concerne les systèmes de fichiers, les logiciels utilitaires, ainsi que 1 742 fonctions de l'interface de programmation[53]. Le nom « Unix » appartient à l'Open Group et tout système d'exploitation doit être conforme à la Single Unix Specification pour être reconnu comme faisant partie de la famille Unix[54].

Microsoft et la concurrence |

En 1995, conformément au Sherman Antitrust Act — une loi des États-Unis pour la prévention de l'abus de position dominante, le département de la justice des États-Unis interdit à Microsoft certaines de ses pratiques considérées comme nuisibles à la concurrence. Deux ans plus tard, un procès est ouvert pour non-respect des interdictions de 1995 : Microsoft obtient l'annulation du procès sur l'argument que « la justice n'est pas équipée pour juger du bien-fondé du design des produits de haute technologie (sic) ».

Entre 1999 et 2001, une enquête est ouverte concernant la position de Microsoft. L'enquête, menée par les juges Thomas Jackson et Richard Posner, amène à la conclusion que Microsoft abuse de sa position de monopole pour pratiquer du « favoritisme » sur le marché connexe des navigateurs Web, des pratiques qui nuisent à ses concurrents, gênent leur émergence et freinent l'innovation[55]. La société échappe de peu à la scission, et se retrouve dans l'obligation de publier les spécifications de ses technologies, en particulier les interfaces de programmation et les protocoles réseau, ceci afin de préserver l'interopérabilité et la concurrence[56].

Plus tard, en 2007, Microsoft est condamné par la Commission européenne à une amende de près de 500 millions d'euros pour violation de l'article 82 du traité CE et l'article 54 de l'accord EEE (textes relatifs au droit de la concurrence et l'abus de position dominante) après avoir refusé de publier une de ses spécifications techniques à son concurrent Sun Microsystems[N 19]. Selon la Commission européenne, les agissements de Microsoft nuisent à l'interopérabilité des systèmes d'exploitation et à la concurrence[57].

Les réseaux informatiques |

Chaque système d'exploitation comporte une palette de programmes relatifs aux protocoles réseau. La composition de la palette dépend du choix de l'éditeur et diffère d'un système d'exploitation à l'autre. Toutefois, deux ordinateurs ne peuvent communiquer ensemble qu'à la condition unique d'utiliser les mêmes protocoles.

La popularisation d'Internet dans les années 1990 a poussé de nombreux éditeurs à inclure dans leur système d'exploitation des programmes relatifs aux protocoles TCP/IP (les protocoles d'Internet), améliorant ainsi l'interopérabilité entre les systèmes d'exploitation.

Notes et références |

Notes |

Plus précisément, ni le code, ni les données, ni la pile n'ont besoin d'être totalement en mémoire centrale.

Le fait de transférer un segment complet en mémoire de masse est nommé swap out, l'opération inverse swap in.

D'abord sous forme de téléscripteurs, puis de terminaux passifs.

Le langage C est un langage de programmation souvent utilisé pour les systèmes d'exploitation en raison de sa puissance et du contrôle total qu'a le programmeur sur la mémoire (A. Tanenbaum, Systèmes d'exploitation, 1.8).

Ce mécanisme qui permet au système d'interrompre un programme en cours d'exécution est nommé préemption (A. Tanenbaum, ibid., 2.4.1, p. 140).

La totalité du code source se trouve dans son livre Operating Systems : Design and Implementation.

L'élimination des limitations de Minix aurait rendu le code source trop difficile à lire et à comprendre par les étudiants en un semestre (A. Tanenbaum, ibid., 10.1.7, p. 766).

Andrew Tanenbaum, enseignant, utilisait le code source de Minix pour illustrer ses cours sur les systèmes d'exploitation.

anciennement appelé EPOC.

racheté à Psion.

Compatible PC, Macintosh, DEC Alpha, Sparc, Itanium, m68k, etc.

Via la branche du noyau Linux-rt.

Entre 1986 et 1991, les produits de la famille Windows étaient des environnement graphique pour le système d'exploitation DOS.

Scission du projet 386BSD.

Plus de 50 types de machines. Cf. (en) Liste des plateformes compatibles avec NetBSD.

Compatible PC, ARM, MIPS, Macintosh, DEC Alpha, Sparc, Itanium, Sun Microsystems, Xbox.

Compatible PC, ARM, DEC Alpha, Sparc, etc.

Créé par fusion entre NeXTSTEP et Mac OS.

L'échange de spécifications est une pratique courante dans le marché informatique.

Références |

(en) Brian L. Stuart, Principles of Operating Systems: Design & Applications, Cengage Learning EMEA, 2008 (ISBN 978-1418837693).

(en) I. A. Dhotre, Operating Systems, Technical Publications, 2009 (ISBN 978-8-1843-1644-5).

(en) Achyut S. Godbole et Atul Kahate, Operating Systems, 3e ed., Tata McGraw-Hill Education, 2011 (ISBN 978-0-0707-0203-5)

(en) Top 5 Operating Systems from July 2008 to April 2012 - StatCounter Global Stats

(en)Pabitra Pal Choudhury, Operating Systems: Principles and Design, Prentice-Hall of India Pvt. Ltd, 2009 (ISBN 978-8-1203-3811-1).

(en)Sibsankar Haldar et Alex A. Aravind,Operating Systems, Pearson Education India - 2010, (ISBN 9788131730225)

(en)Jose Garrido, Richard Schlesinger et Kenneth Hoganson,Principles of Modern Operating Systems,Jones & Bartlett Publishers - 2011, (ISBN 9781449626341)

(en)Operating Systems,Technical Publications, (ISBN 9788184315622)

(en)Balagurusamy,Fund Of Computers, Tata McGraw-Hill Education, (ISBN 9780070141605)

(en),Operating Systems: Principles And Design,PHI Learning Pvt. Ltd. - 2009, (ISBN 9788120338111)

(en) George A. Anzinger et Adele M. Gadol, « A Real-Time Operating System with Multi-Terminals and Batch/Spool capablities », HP journal, 1975(lire en ligne [PDF]).

(en) Pramod Chandra P. Bhatt, An Introduction To Operating Systems: Concepts and Practice, 2d Ed., Prentice-Hall of India Pvt. Ltd, 2007, (ISBN 9788120332584)

(en) Amjad Umar, Third Generation Distributed Computing Environments, NGE Solutions Inc, 2004, (ISBN 9780975918210)

(en) Godbole, OPERATING SYSTEM 3E, Tata McGraw-Hill Education, 2011, (ISBN 9780070702035)

« MIT - General Electric, Honeywell-Bull - MULTICS », sur feb-patrimoine.com (consulté le 30 septembre 2013)

(en) Ayan Moumina, « History of operating systems » [PDF] (consulté le 30 septembre 2013).

(en) Mark Bellis, « Putting Microsoft on the Map - History of the MS-DOS Operating Systems, IBM & Microsoft », sur about.com (consulté le 30 septembre 2013).

(en) « History of the graphical user interface », sur sensomatic.com (consulté le 30 septembre 2013).

« L'annonce originale du projet GNU », sur gnu.org, 27 septembre 1983(consulté le 30 septembre 2013)

(en) Richard Stallman, « The Hurd and Linux » (consulté le 30 septembre 2013)

(en) Linus Torvalds, « RELEASE NOTES FOR LINUX v0.12 », The Linux Kernel Archives, 5 janvier 1992(consulté le 30 septembre 2013)

(en) Josh Schneider, « Finding aid to the Berkeley Software Distribution » [PDF] (consulté le 30 septembre 2013), p. 3.

(en) Elizabeth U. Harding, « Unix pioneer ends BSD research », Software Magazine, octobre 1992(lire en ligne)

(en) Working group on Libre Software, Free Software / Open Source: Information Society Opportunities for Europe?, avril 2000(lire en ligne), « A brief history of open open source software »

(en)Michael Kifer, Scott Smolka,Introduction to Operating System Design and Implementation: The OSP 2 Approach, Springer Science & Business Media - 2007, (ISBN 9781846288432)

(en)Operating Systems: Principles And Design,PHI Learning Pvt. Ltd., 2009, (ISBN 9788120338111)

(en)Er. Vivek Sharma - Er. Manish Varshney et Shantanu Sharma,Design and Implementation of Operating System,Laxmi Publications, Ltd. - 2010, (ISBN 9789380386416)

(en)Brian L. Stuart,Principles of Operating Systems: Design & Applications,Cengage Learning EMEA - 2008, (ISBN 9781418837693)

« Théorie des systèmes d'exploitation : Introduction », sur http://doc.esaip.org (consulté le 18 janvier 2018), p. 7

(en) « Amiga Operating System Freqently Asked Questions », sur CineReal, 2005(consulté le 30 septembre 2013)

(en) « IBM AIX Systems management - Desktop », IBM (consulté le 30 septembre 2013)

(en) Andy Tanenbaum, « Introduction to Minix 3 », OSNews, 25 septembre 2006(consulté le 30 septembre 2013)

(en) John Pagonis, « Symbian OS Presentation » [PDF], 2 mars 2004(consulté le 30 septembre 2013).

(en) « Kernel.exe Describes the Kernel and VxD for Windows 95 », sur support.microsoft.com (consulté le 30 septembre 2013)

(en) « Windows CE and Windows Mobile Timeline »(Archive • Wikiwix • Archive.is • Google • Que faire ?)

(en) « Windows CE Kernel services », Microsoft Developper Network (consulté le 30 septembre 2013)

^ http://www.lembarque.com/lextension-temps-reel-rtx-pour-windows-passe-au-64-bits_000132

« Chiffres clés : les systèmes d’exploitation sur PC »

(en) « Windows market share drop to 15 years low », TG Daily (consulté le 30 septembre 2013)

(en) Sebastian Anthony, « Microsoft's share of the consumer market has dropped from 95% to 20% in 8 years », ExtremeTech (consulté le 30 septembre 2013)

(en) « Unix Flavor List », sur about.com (consulté le 30 septembre 2013).

(en) Jeff Drew, « IDC report: IBM widens lead as server market shrinks again », Triangle Business Journal, 2 septembre 2009(consulté le 30 septembre 2013).

(en) « Usage of operating systems for websites », W3Techs - Web Technology Surveys, septembre 2013(consulté le 30 septembre 2013).

(en) « The triumph of Linux as supercomputer OS », sur Royal Pingdom (consulté le 30 septembre 2013).

« Canalys, 115 millions de smartphones en 2007 », GNT - portail des nouvelles technologies et du jeu (consulté le 30 septembre 2013) : « Sur l'ensemble de l'année, le système d'exploitation Symbian occupe 67 % de parts de marché, Windows Mobile 13 % et RIM 10 % ».

(en) Emil Protalinski, « Android grabs 75% market share in Q3, followed by 14,9% for iOS and 4,3% for BlackBerry », TheNextWeb (consulté le 30 septembre 2013).

« Tablettes tactiles : 83,9 % de part de marché pour Apple iOS », Journal du Net, 11 avril 2011(consulté le 30 septembre 2013).

(en) « Worldwide Tablet Market Surges Ahead on Strong First Quarter Sales, Says IDC », International Data Corporation, 1er mai 2013(consulté le 30 septembre 2013).

(en) « Linux Rules Supercomputers », sur forbes.com, 15 mars 2005(consulté le 30 septembre 2013) : « Linux now has become so technically powerful that it lays claim to a prestigious title–it runs more of the world’s top supercomputers ».

Cf. (en) Michael Kerrisk, The LINUX Programming Interface, San Francisco, No starch Press, 2010, 1508 p. (ISBN 9781593272203), « History and Standards », p. 3.

(en) « Unix history and timeline », sur unix.org (consulté le 30 septembre 2013).

(en) « POSIX.1 FAQ », sur opengroup.org, 5 octobre 2011(consulté le 30 septembre 2013).